L’ordinateur quantique : pour qui ? pourquoi ?

1 août 2025 Rédaction Aucun commentaire Découvrir algorithme de Shor, Amazon, Etats Unis, Google, intelligence artificielle, Microsoft, qubits 3580 vues

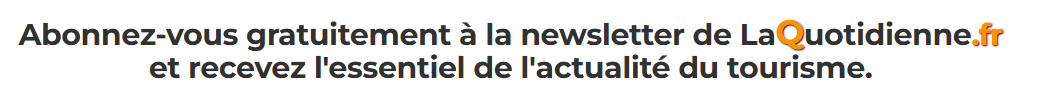

L’ordinateur quantique n’est pas une simple évolution de l’ordinateur classique ; c’est une révolution qui exploite les principes étranges et fascinants de la mécanique quantique pour traiter l’information. Son histoire est relativement jeune, mais pleine de percées théoriques et technologiques.

Les Prémices Théoriques (Années 1980)

L’idée d’un ordinateur quantique a émergé dans les années 1980, lorsque les scientifiques ont commencé à réaliser que les ordinateurs classiques avaient des limites fondamentales face à certains problèmes complexes, notamment la simulation de systèmes quantiques eux-mêmes.

L’idée d’un ordinateur quantique a émergé dans les années 1980, lorsque les scientifiques ont commencé à réaliser que les ordinateurs classiques avaient des limites fondamentales face à certains problèmes complexes, notamment la simulation de systèmes quantiques eux-mêmes.

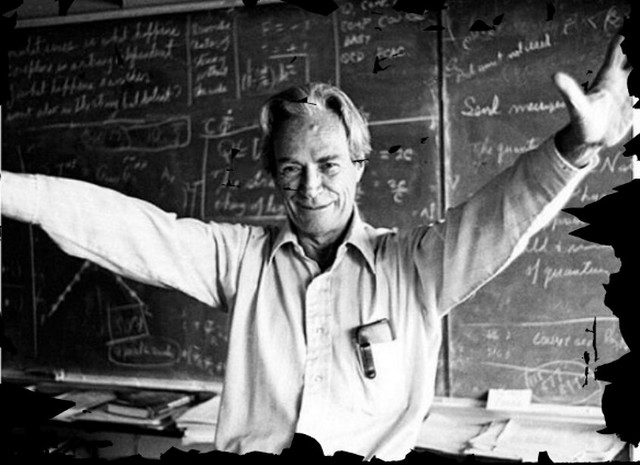

Richard Feynman

C’est le physicien lauréat du prix Nobel en 1981, Richard Feynman, qui est souvent crédité d’avoir posé la question cruciale : si la nature est quantique, pourquoi essayons-nous de la simuler avec des machines classiques ?

Lors d’une conférence, il a suggéré l’idée de construire des machines qui exploitent directement les phénomènes quantiques pour effectuer des calculs.

Pour lui, un simulateur quantique serait le moyen le plus efficace de comprendre les systèmes quantiques.

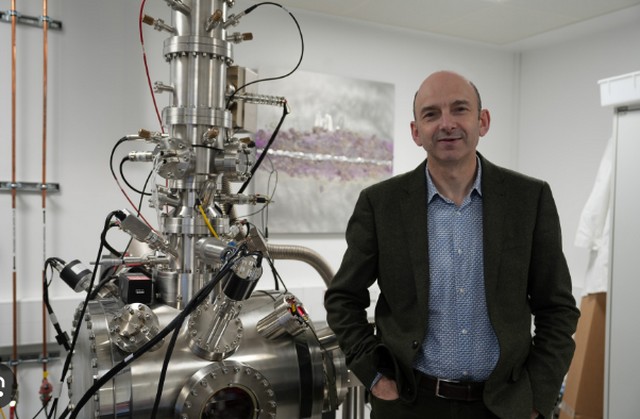

David Deutsch

Quelques années plus tard, en 1985, David Deutsch, physicien à l’université d’Oxford, a formalisé le concept de l’ordinateur quantique universel.

Quelques années plus tard, en 1985, David Deutsch, physicien à l’université d’Oxford, a formalisé le concept de l’ordinateur quantique universel.

Il a démontré qu’une machine basée sur les principes quantiques pourrait en théorie exécuter n’importe quel calcul que n’importe quel autre ordinateur quantique pourrait exécuter.

C’était une avancée majeure, car elle prouvait la faisabilité théorique d’une telle machine.

Les Premiers Algorithmes et la « Course » (Années 1990)

Les années 1990 ont vu l’émergence d’algorithmes quantiques qui ont mis en évidence le potentiel colossal de ces machines, déclenchant un véritable engouement pour la recherche.

Peter Shor, alors aux Bell Labs, a développé un algorithme quantique capable de factoriser rapidement de grands nombres.

Peter Shor, alors aux Bell Labs, a développé un algorithme quantique capable de factoriser rapidement de grands nombres.

Cette découverte a eu l’effet d’une bombe, car la sécurité de la plupart des cryptographies modernes (comme le chiffrement RSA, utilisé pour les transactions bancaires et la communication sécurisée) repose sur la difficulté pour les ordinateurs classiques de factoriser de très grands nombres.

L’algorithme de Shor a montré qu’un ordinateur quantique suffisamment puissant pourrait briser ces chiffrements, soulevant d’énormes questions sur la cybersécurité future.

Les Premières Réalisations Physiques (Fin des années 1990 – 2000)

La théorie étant posée, le défi est devenu de construire physiquement ces machines.

La théorie étant posée, le défi est devenu de construire physiquement ces machines.

Au cours des années 2000, différentes approches technologiques pour construire des qubits ont été explorées : les supraconducteurs (IBM, Google), les ions piégés (IonQ, Honeywell), les points quantiques, les photons, etc.

Chaque approche a ses avantages et ses défis en termes de stabilité, de cohérence et de scalabilité des qubits.

L’Ère de la « Suprématie Quantique » et au-delà (Années 2010 – Aujourd’hui)

La dernière décennie a été marquée par des avancées spectaculaires, bien que des défis majeurs persistent.

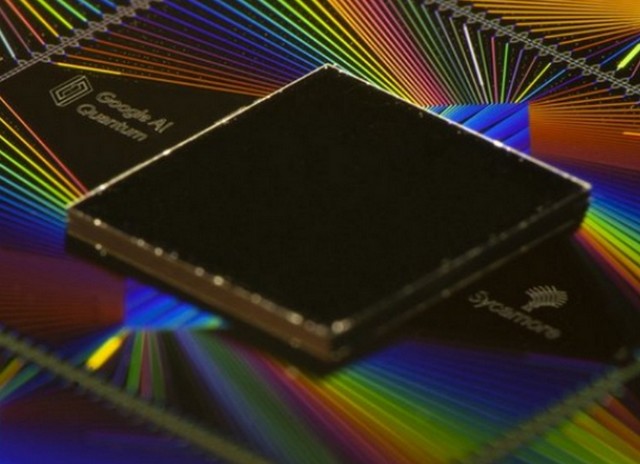

En 2019, Google a affirmé avoir atteint la « suprématie quantique » (ou avantage quantique) avec son processeur Sycamore à 53 qubits.

En 2019, Google a affirmé avoir atteint la « suprématie quantique » (ou avantage quantique) avec son processeur Sycamore à 53 qubits.

Ils ont démontré que cet ordinateur pouvait effectuer une tâche de calcul spécifique en 3 minutes et 20 secondes, alors que le supercalculateur classique le plus rapide aurait mis environ 10 000 ans pour la même tâche.

Bien que la tâche en question n’ait pas d’application pratique immédiate, cette démonstration a marqué un jalon symbolique important, prouvant qu’un ordinateur quantique peut dépasser les capacités des ordinateurs classiques pour un problème donné.

Les développements actuels

Aujourd’hui, des géants de la technologie comme IBM, Google, Microsoft, Amazon, ainsi que de nombreuses startups et des institutions de recherche à travers le monde, investissent massivement dans l’informatique quantique.

Aujourd’hui, des géants de la technologie comme IBM, Google, Microsoft, Amazon, ainsi que de nombreuses startups et des institutions de recherche à travers le monde, investissent massivement dans l’informatique quantique.

Les efforts se concentrent sur :

L’augmentation du nombre de qubits. L’amélioration de la cohérence (la durée pendant laquelle les qubits peuvent maintenir leur état quantique fragile). La réduction des taux d’erreur. Le développement de logiciels, d’algorithmes et de langages de programmation spécifiques au quantique.

Des Défis Persistants néanmoins

Malgré ces avancées, l’ordinateur quantique universel et tolérant aux pannes (capable de corriger ses erreurs) est encore un objectif lointain.

Malgré ces avancées, l’ordinateur quantique universel et tolérant aux pannes (capable de corriger ses erreurs) est encore un objectif lointain.

Les principaux défis sont la décohérence : Les qubits sont extrêmement sensibles à leur environnement et perdent rapidement leurs propriétés quantiques.

L’erreur quantique : Les opérations sur les qubits sont sujettes aux erreurs, et la correction d’erreurs quantiques est un domaine de recherche très complexe.

Et la scalabilité : Construire et contrôler des milliers, voire des millions, de qubits stables et connectés est un immense défi d’ingénierie.

L’histoire de l’ordinateur quantique est celle d’une idée audacieuse qui est progressivement passée de la théorie pure à des démonstrations physiques concrètes.

Nous sommes encore aux balbutiements de cette technologie, mais son potentiel pour résoudre des problèmes actuellement insolubles reste une source d’immense excitation et de recherche intense.

Sur le même sujet

Machine arrière #1 : le radio-transistor

Machine arrière s’installe à la Cité des sciences et de l’industrie ! Un concept...

A Kyoto, découvrez la beauté des ombrelles wagasa

Le Wagasa (和傘), littéralement « parapluie japonais », est bien plus qu’un simple accessoire de protection...

Dans quel monde Vuitton ?

Paris, capitale de l’élégance et du chic, est le berceau de nombreuses légendes du...